區別,定義,聚類方法,統計量,分層步驟,K-means,過程,算法原理,分析模型,有關統計,兩組判別,因子分析模型,主要套用,商業,生物,地理,保險行業,網際網路,電子商務,主要步驟,算法,

區別

聚類與分類的不同在於,聚類所要求劃分的類是未知的。

聚類是將

數據分類到不同的類或者簇這樣的一個過程,所以同一個簇中的對象有很大的相似性,而不同簇間的對象有很大的相異性。

從統計學的觀點看,聚類分析是通過

數據建模簡化數據的一種方法。傳統的統計聚類分析方法包括

系統聚類法、

分解法、加入法、動態聚類法、有序樣品聚類、有重疊聚類和模糊聚類等。採用k-

均值、k-中心點等

算法的聚類分析工具已被加入到許多著名的統計分析

軟體包中,如

SPSS、

SAS等。

從機器學習的角度講,簇相當於隱藏模式。聚類是搜尋簇的

無監督學習過程。與分類不同,

無監督學習不依賴預先定義的類或帶類標記的訓練實例,需要由聚類學習算法自動確定標記,而分類學習的實例或

數據對象有類別標記。聚類是觀察式學習,而不是示例式的學習。

聚類分析是一種探索性的分析,在分類的過程中,人們不必事先給出一個分類的標準,聚類分析能夠從樣本數據出發,自動進行分類。聚類分析所使用方法的不同,常常會得到不同的結論。不同研究者對於同一組數據進行聚類分析,所得到的聚類數未必一致。

從實際套用的角度看,聚類分析是數據挖掘的主要任務之一。而且聚類能夠作為一個獨立的工具獲得數據的分布狀況,觀察每一簇數據的特徵,集中對特定的聚簇集合作進一步地分析。聚類分析還可以作為其他

算法(如分類和定性歸納算法)的預處理

步驟。

定義

依據研究對象(樣品或指標)的特徵,對其進行分類的方法,減少研究對象的數目。

各類事物缺乏可靠的歷史資料,無法確定共有多少類別,目的是將性質相近事物歸入一類。

各指標之間具有一定的相關關係。

聚類分析(cluster analysis)是一組將研究對象分為

相對同質的群組(clusters)的統計分析技術。 聚類分析區別於分類分析(classification analysis) ,後者是有監督的學習。

變數類型:定類變數、定量(離散和連續)變數

聚類方法

1,層次聚類(Hierarchical Clustering)

2. 非層次聚類

劃分聚類、譜聚類

聚類方法特徵:

聚類分析簡單、直觀。

聚類分析主要套用於探索性的研究,其分析的結果可以提供多個可能的解,選擇最終的解需要研究者的主觀判斷和後續的分析;

不管實際數據中是否真正存在不同的類別,利用聚類分析都能得到分成若干類別的解;

聚類分析的解完全依賴於研究者所選擇的聚類變數,增加或刪除一些變數對最終的解都可能產生實質性的影響。

研究者在使用聚類分析時應特別注意可能影響結果的各個因素。

異常值和特殊的變數對聚類有較大影響

當分類變數的測量尺度不一致時,需要事先做標準化處理。

當然,聚類分析不能做的事情是:

自動發現和告訴你應該分成多少個類——屬於非監督類分析方法

期望能很清楚的找到大致相等的類或細分市場是不現實的;

樣本聚類,變數之間的關係需要研究者決定;

不會自動給出一個最佳聚類結果;

我這裡提到的聚類分析主要是譜系聚類(hierarchical clustering)和快速聚類(K-means)、兩階段聚類(Two-Step);

根據聚類變數得到的描述兩個個體間(或變數間)的對應程度或聯繫緊密程度的度量。

可以用兩種方式來測量:

1、採用描述個體對(變數對)之間的接近程度的指標,例如“距離”,“距離”越小的個體(變數)越具有相似性。

2、採用表示相似程度的指標,例如“相關係數”,“相關係數”越大的個體(變數)越具有相似性。

計算聚類——距離指標D(distance)的方法非常多:按照數據的不同性質,可選用不同的距離指標。歐氏距離(Euclidean distance)、歐氏距離的平方(Squared Euclidean distance)、曼哈頓距離(Block)、切比雪夫距離(Chebychev distance)、卡方距離(Chi-Square measure) 等;相似性也有不少,主要是皮爾遜相關係數了!

統計量

群重心

群中心

群間距離

分層步驟

定義問題與選擇分類變數

聚類方法

確定群組數目

聚類結果評估

結果的描述、解釋

K-means

屬於非層次聚類法的一種

(1)執行過程

循環:

按就近原則將其餘記錄向凝聚點凝集

用計算出的中心位置重新進行聚類

(2)方法特點

通常要求已知類別數

可人為指定初始位置

節省運算時間

樣本量大於100時有必要考慮

只能使用連續性變數

過程

特點:

自動決定最佳分類數

快速處理大數據集

前提假設:

變數間彼此獨立

模型穩健

算法原理

第一步:逐個掃描樣本,每個樣本依據其與已掃描過的樣本的距離,被歸為以前的類,或生成一個新類

第二步,對第一步中各類依據類間距離進行合併,按一定的標準,停止合併

判別分析 Discriminant Analysis

分類學是人類認識世界的

基礎科學。聚類分析和

判別分析是研究事物分類的基本方法,廣泛地套用於自然科學、社會科學、工農業生產的各個領域。

概述

DA模型

DA有關的統計量

兩組DA

案例分析

判別分析

判別分析是根據表明事物特點的變數值和它們所屬的類,求出

判別函式。根據

判別函式對未知所屬類別的事物進行分類的一種分析方法。核心是考察類別之間的差異。

判別分析

不同:

判別分析和聚類分析不同的在於判別分析要求已知一系列反映事物特徵的數值變數的值,並且已知各個體的分類。

DA適用於定類變數(因)、任意變數(自)

DA目的

建立判別函式

檢查不同組之間在有關預測變數方面是否有顯著差異

決定哪個預測變數對組間差異的貢獻最大

根據預測變數對個體進行分類

分析模型

要先建立判別函式 Y=a1x1+a2x2+...anxn,其中:Y為判別分數(判別值),x1 x2...xn為反映研究對象特徵的變數,a1 a2...an為係數

有關統計

典型相關係數

Wilk's (0, 1) = SSw/SSt for X

組重心

分類矩陣

兩組判別

定義問題

估計DA函式係數

確定DA函式的顯著性

解釋結果

評估有效性

定義問題

判別分析的第一步

第二步就是將樣本分為:

分析樣本

驗證樣本

直接法(direct method)就是同時用所有的預測變數估計

判別函式,此時每個自變數都包括在內,而不考慮其判別能力。這種方法適用於前期研究或

理論模型顯示應包括哪些自變數的情況。

逐步

判別分析(stepwise discriminant analysis),預測變數依據其對組別的判別能力被逐步引入。

確定顯著性

特徵值

典型相關係數

Wilk‘s (0, 1) 轉換成卡方值檢驗

見travel.spo

解釋結果

係數的符號無關緊要,但能夠表示每個變數對

判別函式值的影響,以及與特定組的聯繫。

我們可以通過標準化

判別函式係數的絕對值初步判斷變數的相對重要性。

通過考察結構

相關係數,也可以對預測變數的相對重要性進行判斷。

組重心

評估判別分析的有效性

根據分析樣本估計出的判別權數,乘以保留樣本中的預測變數值,就得出保留樣本中每個樣本的判別分。

可以根據判別分及適當的規則劃分為不同的組別。

命中率(hit ratio)或稱樣本正確分類

機率,就是分類矩陣對角線元素之和與總樣本數的比例。

比較樣本正確分類百分比與隨機正確分類百分比。

因子分析模型

因子分析模型(FA)

基本思想

因子分析模型

FA的基本思想

“

因子分析”於1931年由Thurstone提出,概念起源於Pearson和Spearmen的統計分析

FA用少數幾個因子來描述多個變數之間的關係,相關性較高的變數歸於同一個因子;

FA利用

潛在變數或本質因子(基本特徵)去解釋可觀測變數

FA模型

X1=a11F1+a12F2+ …+a1pFp+v1

X2=a21F1+a22F2+ …+a2pFp+v2 X=AF+V

Xi=ai1F1+ai2F2+ …+aipFp+vi

Xm=ap1F1+ap2F2+ …+ampFm+vm

Xi — 第i個標準化變數

F — 公因子

Vi — 特殊因子

公因子模型

F1=W11X1+W12X2+ …+W1mXm

F2=W21X1+W22X2+ …+W2mXm

Fi=Wi1X1+Wi2X2+ …+WimXm

Fp=Wp1X1+Wp2X2+ …+WpmXm

Wi — 權重,因子得分係數

Fi — 第i個因子的估計值(因子得分)

有關統計量

Bartlett氏球體檢驗:各變數之間彼此獨立

KMO值:FA合適性

因子負荷矩陣

特徵值

累計方差貢獻率

因子負荷圖

碎石圖

FA步驟

定義問題

檢驗FA方法的適用性

確定因子分析方法

因子旋轉

解釋因子

計算因子得分

注意事項

樣本量不能太小

變數相關性

公因子有實際意義

主要套用

商業

聚類分析被用來發現不同的客戶群,並且通過購買模式刻畫不同的客戶群的特徵。

聚類分析是細分市場的有效工具,同時也可用於研究消費者行為,尋找新的潛在市場、選擇實驗的市場,並作為

多元分析的預處理。

生物

聚類分析被用來動植物分類和對基因進行分類,獲取對種群固有結構的認識

地理

聚類能夠幫助在地球中被觀察的資料庫商趨於的相似性

保險行業

聚類分析通過一個高的平均消費來鑑定汽車保險單持有者的分組,同時根據住宅類型,價值,地理位置來鑑定一個城市的房產分組

網際網路

聚類分析被用來在網上進行文檔歸類來修覆信息

電子商務

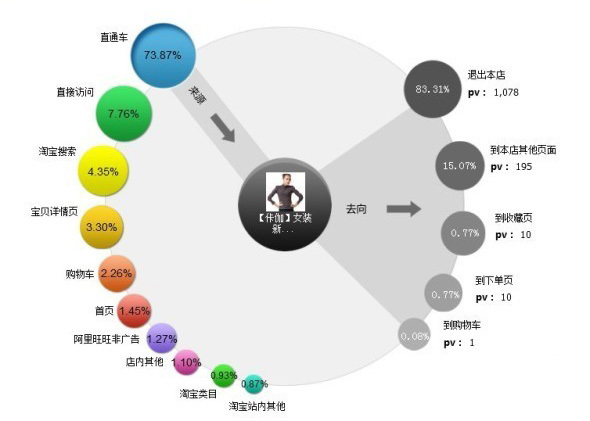

聚類分析在電子商務中網站建設數據挖掘中也是很重要的一個方面,通過分組聚類出具有相似瀏覽行為的客戶,並分析客戶的共同特徵,可以更好的幫助電子商務的用戶了解自己的客戶,向客戶提供更合適的服務。

主要步驟

2. 為衡量數據點間的相似度定義一個距離函式,

3. 聚類或分組,

4. 評估輸出。

數據預處理包括選擇數量,類型和特徵的標度,它依靠特徵選擇和特徵抽取,特徵選擇選擇重要的特徵,特徵抽取把輸入的特徵轉化為一個新的顯著特徵,它們經常被用來獲取一個合適的特徵集來為避免“維數災”進行聚類,數據預處理還包括將

孤立點移出數據,孤立點是不依附於一般數據行為或模型的數據,因此孤立點經常會導致有偏差的聚類結果,因此為了得到正確的聚類,我們必須將它們剔除。

既然相類似性是定義一個類的基礎,那么不同數據之間在同一個特徵空間相似度的衡量對於聚類步驟是很重要的,由於特徵類型和特徵標度的多樣性,

距離度量必須謹慎,它經常依賴於套用,例如,通常通過定義在特徵空間的距離度量來評估不同對象的相異性,很多距離度都套用在一些不同的領域,一個簡單的距離度量,如Euclidean距離,經常被用作反映不同數據間的相異性,一些有關相似性的度量,例如PMC和SMC,能夠被用來特徵化不同數據的概念相似性,在圖像聚類上,子圖圖像的

誤差更正能夠被用來衡量兩個圖形的相似性。

將數據對象分到不同的類中是一個很重要的步驟,數據基於不同的方法被分到不同的類中,劃分方法和層次方法是聚類分析的兩個主要方法,劃分方法一般從初始劃分和最最佳化一個聚類標準開始。Crisp Clustering,它的每一個數據都屬於單獨的類;Fuzzy Clustering,它的每個數據可能在任何一個類中,Crisp Clustering和Fuzzy Clusterin是劃分方法的兩個主要技術,劃分方法聚類是基於某個標準產生一個嵌套的劃分系列,它可以度量不同類之間的相似性或一個類的可分離性用來合併和分裂類,其他的聚類方法還包括基於密度的聚類,基於模型的聚類,基於

格線的聚類。

評估聚類結果的質量是另一個重要的階段,聚類是一個無管理的程式,也沒有客觀的標準來評價聚類結果,它是通過一個類有效索引來評價,一般來說,

幾何性質,包括類間的分離和類內部的耦合,一般都用來評價聚類結果的質量,類有效索引在決定類的數目時經常扮演了一個重要角色,類有效索引的最佳值被期望從真實的類數目中獲取,一個通常的決定類數目的方法是選擇一個特定的類有效索引的最佳值,這個索引能否真實的得出類的數目是判斷該索引是否有效的標準,很多已經存在的標準對於相互分離的類數據集合都能得出很好的結果,但是對於複雜的數據集,卻通常行不通,例如,對於交疊類的集合。

算法

聚類分析是

數據挖掘中的一個很活躍的研究領域,並提出了許多

聚類算法。傳統的聚類算法可以被分為五類:劃分方法、層次方法、基於密度方法、基於格線方法和基於

模型方法。

1 劃分方法(PAM:PArtitioning method) 首先創建k個劃分,k為要創建的劃分個數;然後利用一個循環定位技術通過將對象從一個劃分移到另一個劃分來幫助改善劃分質量。典型的劃分方法包括:

k-means,k-medoids,CLARA(Clustering LARge Application),

CLARANS(Clustering Large Application based upon RANdomized Search).

FCM

2 層次方法(hierarchical method) 創建一個層次以分解給定的

數據集。該方法可以分為自上而下(分解)和自下而上(合併)兩種操作方式。為彌補分解與合併的不足,層次合

並經常要與其它聚類方法相結合,如循環定位。典型的這類方法包括:

BIRCH(Balanced Iterative Reducing and Clustering using Hierarchies) 方法,它首先利用樹的結構對對象集進行劃分;然後再利用其它聚類方法對這些聚類進行最佳化。

CURE(Clustering Using REprisentatives) 方法,它利用固定數目代表對象來表示相應聚類;然後對各聚類按照指定量(向聚類中心)進行收縮。

ROCK方法,它利用聚類間的連線進行聚類合併。

CHEMALOEN方法,它則是在層次聚類時構造動態模型。

3 基於密度的方法,根據密度完成對象的聚類。它根據對象周圍的密度(如DBSCAN)不斷增長聚類。典型的基於密度方法包括:

DBSCAN(Densit-based Spatial Clustering of Application with Noise):該算法通過不斷生長足夠高密度區域來進行聚類;它能從含有噪聲的空間資料庫中發現任意形狀的聚類。此方法將一個聚類定義為一組“密度連線”的點集。

OPTICS(Ordering Points To Identify the Clustering Structure):並不明確產生一個聚類,而是為自動互動的聚類分析計算出一個增強聚類順序。。

4 基於格線的方法,首先將對象

空間劃分為有限個單元以構成

格線結構;然後利用格線結構完成聚類。

STING(STatistical INformation Grid) 就是一個利用格線單元保存的統計信息進行基於格線聚類的方法。

CLIQUE(Clustering In QUEst)和Wave-Cluster 則是一個將基於格線與基於密度相結合的方法。

5 基於模型的方法,它假設每個聚類的模型並發現適合相應模型的數據。典型的基於模型方法包括:

統計方法COBWEB:是一個常用的且簡單的增量式概念聚類方法。它的輸入對象是採用符號量(

屬性-值)對來加以描述的。採用

分類樹的形式來創建一個層次聚類。

CLASSIT是COBWEB的另一個版本.。它可以對連續取值

屬性進行增量式聚類。它為每個結點中的每個屬性保存相應的連續常態分配(均值與方差);並利用一個改進的分類能力描述方法,即不象COBWEB那樣計算離散屬性(取值)和而是對連續屬性求積分。但是CLASSIT方法也存在與COBWEB類似的問題。因此它們都不適合對大資料庫進行聚類處理.

傳統的聚類算法已經比較成功的解決了低維數據的聚類問題。但是由於實際套用

中數據的複雜性,在處理許多問題時,現有的算法經常失效,特別是對於

高維數據和大型數據的情況。因為傳統聚類方法在高維數據集中進行聚類時,主要遇到兩個問題。①高維數據集中存在大量無關的屬性使得在所有維中存在簇的可能性幾乎為零;②

高維空間中數據較低維空間中數據分布要稀疏,其中數據間距離幾乎相等是普遍現象,而傳統聚類方法是基於距離進行聚類的,因此在高維空間中無法基於距離來構建簇。

高維聚類分析已成為聚類分析的一個重要研究方向。同時高維

數據聚類也是聚類技術的難點。隨著技術的進步使得

數據收集變得越來越容易,導致資料庫規模越來越大、複雜性越來越高,如各種類型的貿易交易數據、Web 文檔、基因表達數據等,它們的維度(

屬性)通常可以達到成百上千維,甚至更高。但是,受“維度效應”的影響,許多在低維

數據空間表現良好的聚類方法運用在

高維空間上往往無法獲得好的聚類效果。高維

數據聚類分析是聚類分析中一個非常活躍的領域,同時它也是一個具有挑戰性的工作。高維

數據聚類分析在市場分析、信息安全、金融、娛樂、反恐等方面都有很廣泛的套用。