基本介紹

- 中文名:scribe

- 來源:Facebook

- 用途:收集日誌

- 性質:分析處理

簡介

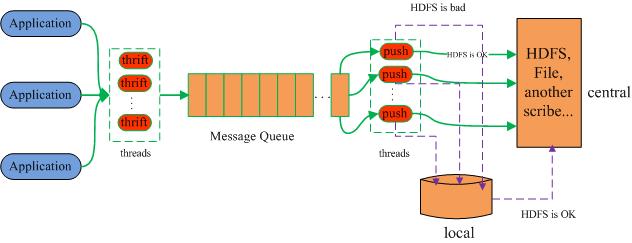

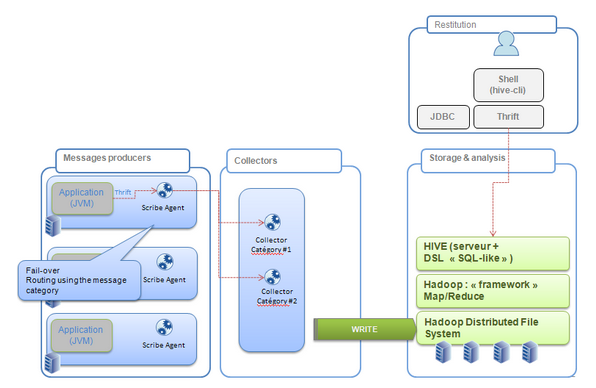

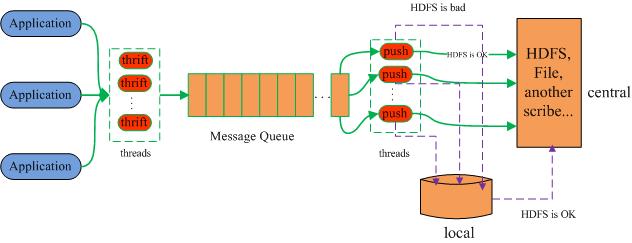

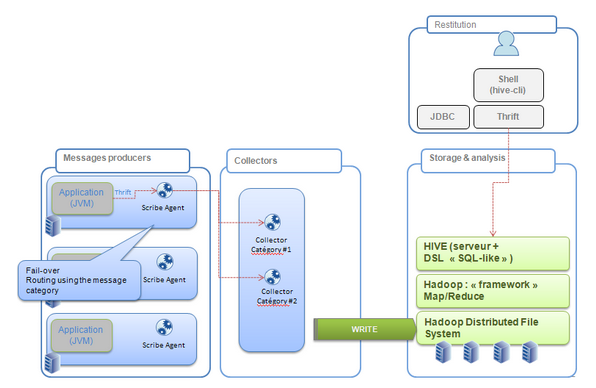

架構

流程原理

Scribe是Facebook開源的日誌收集系統,在Facebook內部已經得到的套用。它能夠從各種日誌源上收集日誌,存儲到一個中央存儲系統(可以是NFS,分散式檔案系統等)上,以便於...

Miniscribe成立於1980年,那一年5.25寸硬碟問世,Miniscribe由於掌握了5.25英寸硬碟的關鍵技術,因此在80年代有著不錯的成績。...

網路訂閱; 預訂; 訂閱subscribe示例 編輯 I've personally never subscribed to the view that either sex is superior to the other....

i.Scribe是一款小巧的EMAIL客戶端軟體,軟體大小為1.73 MB。...... i.Scribe是一款小巧的EMAIL客戶端軟體,軟體大小為1.73 MB。軟體名稱 i.Scribe 軟體平台 p...

SwiftScribe是百度矽谷實驗室(SVAIL)研發的人工智慧網頁套用,可以把音頻資料轉錄成文字。2017年3月,百度推出音頻轉文本套用,暫時免費。目前只測試英文語音,其他語音...

《Numeral Scribe》是一款Android平台的套用。...... Keywords: number, text, converter, numeral, scribe, awesome 此版本中的新功能:-this is the first version...

HTC Scribe 7是一款手機,作業系統 Android2.3。...... HTC Scribe 7是一款手機,作業系統 Android2.3。目錄 1 重要參數 2 詳細參數 HTC Scribe 7重要參數 編輯...

1. 阿爾卡特One Touch Scribe Easy .中關村線上[引用日期2013-03-1] 詞條標籤: 手機 V百科往期回顧 詞條統計 瀏覽次數:次 編輯次數:4次歷史版本 最近更新: 創...

明基16速 DVD+R/-R Light Scribe 1.2版本,盤面設計:用戶可以隨心所欲製作。中文名 明基16速 DVD+R/-R Light Scribe 1.2版本 光碟類型 DVD+R/DVD-R ...

阿爾卡特Scribe HD,是一款電子產品,手機類型是智慧型手機外觀設計:直板式。...... 阿爾卡特Scribe HD,是一款電子產品,手機類型是智慧型手機外觀設計:直板式。...

LightScribe是一種光片標籤製作技術,利用CD或DVD驅動器的雷射燒的文本和圖形直接到特殊塗層的光碟標籤側面貼標盤設定一個標準。[1] ...

WidthScribe是一款適用於Mac作業系統的軟體。...... 圖集 WidthScribe圖冊 V百科往期回顧 詞條統計 瀏覽次數:次 編輯次數:1次歷史版本 最近更新: 創建者:愛不易...

Describe是一種MySQL(關係型資料庫管理系統)的一種命令,用於描述指定數據表的結構。中文名 描述 外文名 Describe Describe the major parts of the Earth....

費倫神系 弱等神力 別稱:文字與圖像之王 Lord of All Glyphs and Images,歐格馬的書記 the Scribe of Oghma 聖徽:背景為紫色,在具有三角瞳孔的紫色眼睛上燃燒...

2. scribe pencil 鉛筆...scribe 文士...chalk line 粉筆線 [1] 3. van si 兵士(binh si): 兵士...文士(van si): 文人...敎師(giao su): 教授...

LEVINE,The Subversive Scribe 7. The Translator-Function:MYRIAM DiAZ—DIOCARETZ Translating Poetic Discourse PART 3:EMBRACING THE FOREIGN 8. Foreignizing ...

Scribe 克萊門斯·史楚錫 Taunting Farmboy Walter Steiner Cavalry Captain Henry van Lyck Wine Server (uncredited) Benedikt Kuby < 上一頁 | 1 | 2 |...

Scribe Albert Egbe 詹森先生職員表 編輯 編劇:William Boyd novel:Joyce Cary 製片人: executive producer:Bill Benenson producer:Michael Fitzgerald executive ...

16 斯克里比 Anthony Scribe 門將 1988-01-01 法國 192 92 15 0 17 努里 Riad Nouri 前腰 1985-06-07 法國 178 73 32 5 18 卡瓦利 Johann Cavalli 前腰...