基本介紹

- 中文名:BP神經網路算法

- 外文名:Back Propagation

- 提出時間:1986年

- 提出者:Rumelhart

BP(Back Propagation)網路是1986年由Rumelhart和McCelland為首的科學家小組提出,是一種按誤差逆傳播算法訓練的多層前饋網路,是目前套用最廣泛的神經網路模型之一。BP...

BP(back propagation)神經網路是1986年由Rumelhart和McClelland為首的科學家提出的概念,是一種按照誤差逆向傳播算法訓練的多層前饋神經網路,是目前套用最廣泛的神經網路...

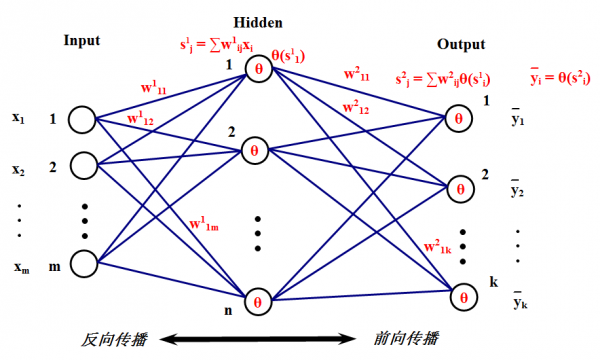

BP(Back Propagation)算法又稱為誤差 反向傳播算法,是人工神經網路中的一種監督式的學習算法。BP 神經網路算法在理論上可以逼近任意函式,基本的結構由非線性變化單元...

利用差錯 矢量對權值進行逐層修改.BP算法有很強的數學基礎,戲劇 性地擴展了神經網路的使用范用,產生了許多套用成功的實 例,對神經網路研究的再次興起起過很大作用...

BP算法是由學習過程由信號的正向傳播與誤差的反向傳播兩個過程組成。由於多層前饋網路的訓練經常採用誤差反向傳播算法,人們也常把將多層前饋網路直接稱為BP網路。...

學習是神經網路一種最重要也最令人注目的特點。在神經網路的發展進程中,學習算法...在主要神經網路如Bp網路,Hopfield網路,ART絡和Kohonen網路中;Bp網路和Hopfield網路...

人工神經網路(Artificial Neural Network,即ANN ),是20世紀80 年代以來人工智慧...迄今,BP算法已被用於解決大量實際問題。1988年,Linsker對感知機網路提出了新的自...

《神經網路計算》是普通高等教育“十五”國家級規劃教材。《神經網路計算》簡要介紹了幾種常用的人工神經網路的原理、計算方法和套用,包括以BP網路為代表的前饋網路,...

神經網路最早由心理學家和神經生物學家提出,由於神經網路在解決複雜問題時能夠...BP神經網路的學習規則, 即權值和閾值的調節規則採用的是誤差反向傳播算法( BP...

的案例(含可運行程式),包括BP、RBF、SVM、SOM、Hopfield、LVQ、Elman、小波等神經網路;還包含PSO(粒子群)、灰色神經網路、模糊網路、機率神經網路、遺傳算法最佳化等...

《神經網路與深度學習 [1] 》,2016年電子工業出版社出版出版的圖書,作者是...3.4 深度學習和神經網路 83 3.5 如何訓練神經網路 84 3.5.1 BP算法:神經網路...

給出了BP網路進行數據壓縮的原理,將圖像先分層n個小塊,對應於輸入的n個神經元,壓縮後的數據對應於隱含層m個神經元,m≦n。通過訓練算法在網路學習過程中調整網路...

BP算法(即反向傳播算法)適合於多層神經元網路的一種學習算法,它建立在梯度下降法的基礎上。BP網路的輸入輸出關係實質上是一種映射關係:一個n輸入m輸出的BP神經...

書中還介紹了人工神經網路套用開發設計的全過程,並在附錄中給出了BP神經網路實現預測、Hop6eld神經網路實現圖像自聯想記憶、模擬退火算法實現TSP和ARTI神經網路的源...

“智慧型算法”是指在工程實踐中,經常會接觸到一些比較“新穎”的算法或理論,比如模擬退火,遺傳算法,禁忌搜尋,神經網路,天牛須搜尋算法等。這些算法或理論都有一些...

3.3.2BP算法及步長調整3.4自適應線性神經網路3.5自組織競爭型神經網路3.5.1自組織競爭型神經網路的基本結構3.5.2自組織競爭型神經網路的學習算法...

第二代神經網路包括比較廣泛,包括套用較多的BP神經網路。但是從本質來講,這些...第二代神經網路模型中難以加入時間,脈衝神經網路(特備當算法定義為離散時間時)...

9.3.2動態BP算法1129.4石灰窯爐的神經網路模型1149.4.1石灰窯爐的生產過程1149.4.2石灰窯的數學模型1159.4.3石灰窯的神經網路模型116...

連線權值進化的進化神經網路神經網路連線權值的調整算法是神經網路設計中的一個關鍵問題。區別與傳統人工神經網路中連線權值調整的BP算法,該進化算法是一種更有效的...

是BP神經網路的一種特殊情形。其特點是有對稱拓撲結構,即輸出量等於輸入量。...而網路自身通常都是對自然界某種算法或者函式的逼近,也可能是對一種邏輯策略的...

遞歸神經網路可以使用監督學習和非監督學習理論進行訓練。在監督學習時,遞歸神經網路使用反向傳播算法(Back-probagation, BP)更新權重參數 [3] ,計算過程可類比循環...