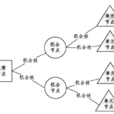

決策樹方法人們把決策問題的自然狀態或條件出現的機率、行動方案、益損值、預測結果等,用一個樹狀圖表示出來,並利用該圖反映出人們思考、預測、決策的全過程。

基本介紹

- 中文名:決策樹方法

- 外文名:decision tree method

決策樹方法人們把決策問題的自然狀態或條件出現的機率、行動方案、益損值、預測結果等,用一個樹狀圖表示出來,並利用該圖反映出人們思考、預測、決策的全過程。

決策樹方法人們把決策問題的自然狀態或條件出現的機率、行動方案、益損值、預測結果等,用一個樹狀圖表示出來,並利用該圖反映出人們思考、預測、決策的全過程。...

決策樹(Decision Tree)是在已知各種情況發生機率的基礎上,通過構成決策樹來求取淨現值的期望值大於等於零的機率,評價項目風險,判斷其可行性的決策分析方法,是直觀...

決策樹分析法是一種運用機率與圖論中的樹對決策中的不同方案進行比較,從而獲得最優方案的風險型決策方法。圖論中的樹是連通且無迴路的有向圖,入度為0的點稱為...

決策樹算法是一種逼近離散函式值的方法。它是一種典型的分類方法,首先對數據進行處理,利用歸納算法生成可讀的規則和決策樹,然後使用決策對新數據進行分析。本質上...

決策樹分析法是指分析每個決策或事件(即自然狀態)時,都引出兩個或多個事件和不同的結果,並把這種決策或事件的分支畫成圖形,這種圖形很像一棵樹的枝幹,故稱決策...

決策樹歸納法(DTI),又稱“決策圖”,是歸納式學習法中最簡單的一支。它是將決策過程各個階段之間的邏輯結構繪成一張箭線圖,再根據決策樹進行分析計算,從而得出...

統計學,數據挖掘和機器學習中的決策樹訓練,使用決策樹作為預測模型來預測樣本的類標。這種決策樹也稱作分類樹或回歸樹。在這些樹的結構里,葉子節點給出類標而內部...

決策樹模型是一種簡單易用的非參數分類器。它不需要對數據有任何的先驗假設,計算速度較快,結果容易解釋,而且穩健性強...

計算動詞決策樹是計算動詞理論與傳統決策樹相結合的產物,也可以說是對傳統決策樹的計算動詞化。對傳統決策樹的計算動詞化有多種方式:第一,我們可以對傳統決策樹所...

《管理決策方法》是2010年清華大學出版社出版的圖書,作者是王延章、郭崇慧、葉鑫。...... 最小支撐樹、最大流和計畫評審與最佳化問題及其決策方法,時間序列預測、因果...

效用分析決策法是風險型決策的基本方法之一。它是利用效用價值的理論和方法,對風險和收益進行比較,從而進行決策的方法。它不僅為諮詢部門提供了判斷決策者所提供的...

數學分析方法是是一種運用數學方法對可以定量化的決策問題進行研究,解決決策中的數量關係的決策分析方法,產生於第二次世界大戰期間。自20世紀70年代以來廣泛套用於...

計量決策法是建立在數學公式計算基礎上的一種決策方法,是運用統計學、運籌學、電子計算機等科學技術,把決策的變數(影響因素)與目標,用數學關係表示出來,求出方案的...

整體框架。主要內容包括線性規劃、整數線性規劃、目標規劃和非線性規劃,圖與網路、運輸問題、最短路線、最小支撐樹、最大流和計畫評審與最佳化問題及其決策方法,時間序...

《機器學習方法》一書比較全面系統地介紹了機器學習的方法和技術,不僅詳細闡述了...全書共分為13章,分別介紹了機器學習的基本概念、最近鄰規則、貝葉斯學習、決策樹...

採用定性分析或定量分析方法進行決策的技術。...... 2.邊際分析法(Marginal analysis)3.(淨)現值分析法——NPV法4.期望值法——決策樹法5.運籌學方法6.矩陣分析...

對於每一個節點,隨機選擇m個特徵,決策樹上每個節點的決定都是基於這些特徵確定的。根據這m個特徵,計算其最佳的分裂方式。 每棵樹都會完整成長而不會剪枝,這有可能...

相關樹的基本原理是借用決策概念來評價未來目標,選擇為達到目標所需發展的技術領域。 按系統分析的觀點, 若一整體系統必須滿足一定條件,則各級子系統也必須滿足相應...

C4.5就是一個決策樹算法,它是決策樹(決策樹也就是做決策的節點間像一棵樹一樣的組織方式,其實是一個倒樹)核心算法ID3的改進算法,所以基本上了解了一半決策樹...

ID3算法是一種貪心算法,用來構造決策樹。ID3算法起源於概念學習系統(CLS),以信息熵的下降速度為選取測試屬性的標準,即在每個節點選取還尚未被用來劃分的具有最高...