基本介紹

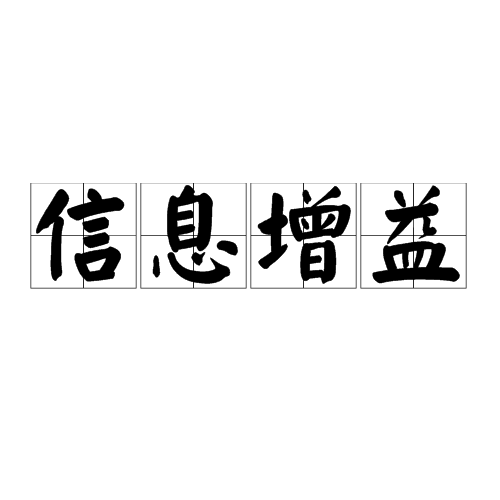

- 中文名:信息增益

- 外文名:Kullback–Leibler divergence

- 又稱:information divergence

- 定義:機率分布

概念

定義

特徵選擇

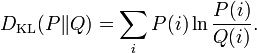

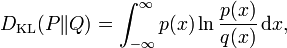

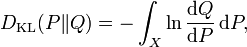

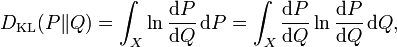

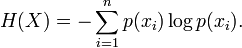

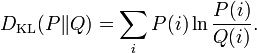

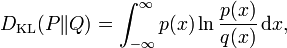

熵公式

熵公式

熵公式

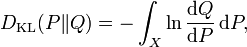

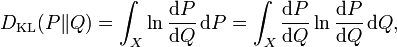

熵公式信息增益(Kullback–Leibler divergence)又叫做information divergence,relative entropy 或者KLIC。在機率論和資訊理論中,信息增益是非對稱的,用以度量兩種機率分布P和Q的...

信息增益率,是一種增益率,數學名詞。...... 即:信息增益率的計算在掌握了信息增益的計算的基礎上,需要知道分母怎么算,分母的算法與E(S,A)的算法不同,再舉一...

信息增益 又稱 information divergence 簡稱 KLIC 信息增益(Kullback–Leibler divergence)又稱information divergence,information gain(IG),relative entropy 或者KLIC...

《信息與自組織》是2010年四川教育出版社出版的圖書,作者是H.哈肯。本書適宜於自然科學、社會科學各門類不同程度的科學工作者、大專院校師生閱讀,也適宜於具有中等...

經濟信息傳遞是經濟信息的增益循環過程。在生產和科技活動進程中,首先形成一個包括人力、實物(原材料、成品、設備和能量等)和貨幣在內的物質流。人力、實物和貨幣在...

《信息內容安全管理及套用》是2010年機械工業出版社出版的圖書,作者是李建華。...... 3.3.5 信息增益 353.3.6 卡方統計 363.4 特徵重構 363.4.1 詞幹 3...

ID3算法是一種貪心算法,用來構造決策樹。ID3算法起源於概念學習系統(CLS),以信息熵的下降速度為選取測試屬性的標準,即在每個節點選取還尚未被用來劃分的具有最高...

ID3,C4.5 和C5.0決策樹的生成使用信息增益。信息增益 是基於資訊理論中信息熵的理論。決策樹學習決策樹的優點 編輯 與其他的數據挖掘算法相比,決策樹有許多優點:...

樹由一單一節點表示訓練樣本開始(步驟 1),若樣本含相同類,則節點為葉且註標為此類(步驟 2、 3); 否則,算法使用系統亂度導向稱為信息增益法為經驗法則,以選...

特徵提取是計算機視覺和圖像處理中的一個概念。它指的是使用計算機提取圖像信息,決定每個圖像的點是否屬於一個圖像特徵。特徵提取的結果是把圖像上的點分為不同的子...

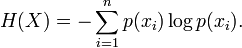

ID3選擇屬性用的是子樹的信息增益,這裡可以用很多方法來定義信息,ID3使用的是熵(entropy, 熵是一種不純度度量準則),也就是熵的變化值,而C4.5用的是信息增益率...

7對該屬性進行離散化8選擇候選屬性attribute_list中具有最高信息增益率的屬性D9標記節點N為屬性D10for each 屬性D的一致值d11由節點N長出一個條件為D=d的分支...