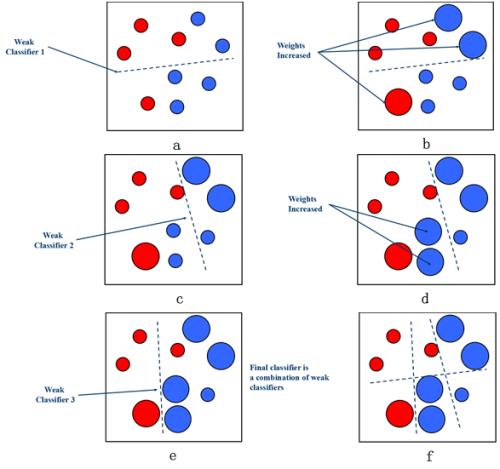

Adaboost是一種疊代算法,其核心思想是針對同一個訓練集訓練不同的分類器(弱分類器),然後把這些弱分類器集合起來,構成一個更強的最終分類器(強分類器)。

基本介紹

簡介

算法簡介

Adaboost

Adaboost算法套用

算法分析

過程分析

Adaboost

Adaboost算法優缺點

Adaboost

Adaboost

Adaboost是一種疊代算法,其核心思想是針對同一個訓練集訓練不同的分類器(弱分類器),然後把這些弱分類器集合起來,構成一個更強的最終分類器(強分類器)。

Adaboost

Adaboost Adaboost

Adaboost Adaboost

AdaboostAdaboost是一種疊代算法,其核心思想是針對同一個訓練集訓練不同的分類器(弱分類器),然後把這些弱分類器集合起來,構成一個更強的最終分類器(強分類器)。...

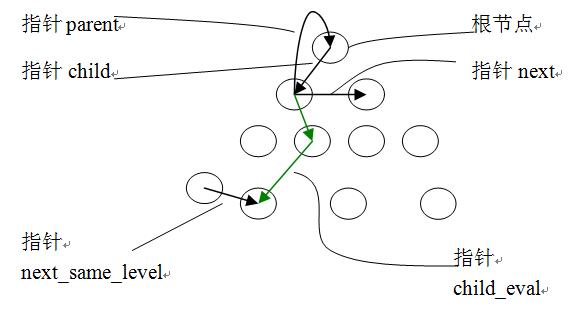

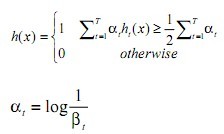

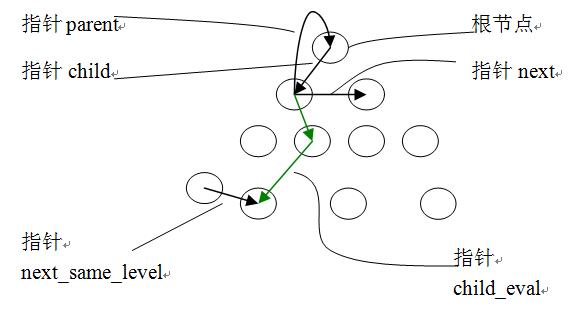

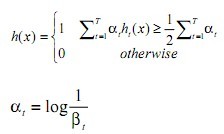

AdaBoost 是Boosting 算法家族中代表算法,AdaBoost 主要是在整個訓練集上維護一個分布權值向量 Dt( x) ,用賦予權重的訓練集通過弱分類算法產生分類假設 Ht ( x)...

Adaboost算法中的一種,對傳統的adaboost算法的改進,用來解決多類單標籤問題。 ...... Adaboost算法中的一種,對傳統的adaboost算法的改進,用來解決多類單標籤問題...

因為Ada Boost 算法對分類錯誤的樣本進行加權處理,在下一輪的疊代訓練中這些樣本將被重點學習分類,所以 Ada Boost 算法有著較強的分類能力。可是,一旦分類訓練中...

行人檢測方法中主要用到的分類器有支持向量機(SVM)、Adaboost和神經網路分類器,下面分別對這幾種分類器進行概述。行人檢測SVM分類器 ...

行人檢測方法中主要用到的分類器有支持向量機(SVM)、Adaboost和神經網路分類器,下面分別對這幾種分類器進行概述。行人檢測器SVM分類器 Vapnik 提出的支持向量機 ...

第4至11章詳細介紹了幾種常見的分類模型,包括樸素貝葉斯模型、K近鄰模型、決策樹模型、Logistic回歸模型、支持向量機模型、隨機森林模型、AdaBoost模型和提升樹模型,...

9.5 Adaboost分類器9.5.1 Adaboost算法9.5.2 Adaboost算法分析9.5.3 Adaboost算法拓展參考文獻第10章 評價指標與評測比較10.1 評價指標...

1.Ou,Zongying; Tang,Xusheng; Su,Tieming; Zhao,Pengfei,Cascade AdaBoost classifiers with stage optimization for face detection,Lecture Notes in Computer ...

▪ 12:BIRCH ▪ 13:AdaBoost ▪ 14:GSP ▪ 15:PrefixSpan 數據挖掘算法概念描述 編輯 算法使用此分析的結果來定義用於創建挖掘模型的最佳參數。然後...