基本介紹

- 中文名:部分可觀察馬爾可夫決策過程

- 外文名:Partially Observable Markov Decision Process

定義

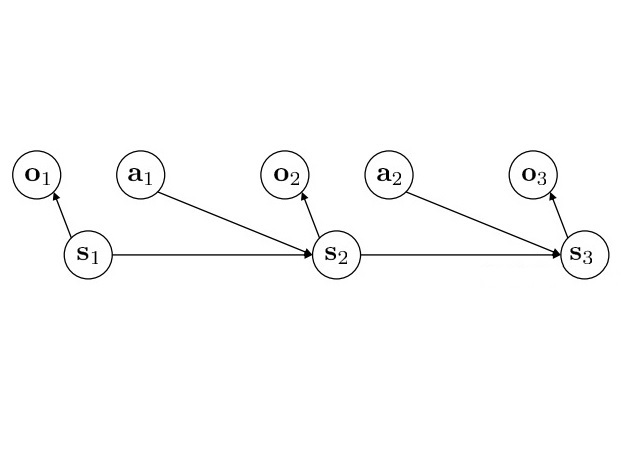

部分可觀察馬爾可夫決策過程(Partially Observable Markov Decision Process,縮寫:POMDP),是一種通用化的馬爾可夫決策過程。POMDP模擬智慧型體決策程式是假設系統動態由MDP...

部分可觀察馬爾可夫決策過程(Partially Observable Markov Decision Process,縮寫:POMDP),是一種通用化的馬爾可夫決策過程。...

馬爾可夫決策過程(Markov Decision Process, MDP)是序貫決策(sequential decision)的數學模型,用於在系統狀態具有馬爾可夫性質的環境中模擬智慧型體可實現的隨機性策略與...

馬爾可夫鏈(Markov Chain, MC)是機率論和數理統計中具有馬爾可夫性質(Markov property)且存在於離散的指數集(index set)和狀態空間(state space)內的隨機過程(...

目錄多智慧型體系統及套用(卷二)專題6部分可觀察環境中的序貫決策理論及方法研究章宗長1引言2部分可觀察馬爾可夫決策過程3離線規劃方法...

9.2.1 馬爾可夫決策過程MDP(MarkovDecisionProcess) 819.2.2 部分可觀察馬爾可夫決策過程POMDP 829.3 潛意識馬爾可夫決策過程 839.3.1 潛意識決策思維定性描述 839.3...

郭先平教授從事馬爾可夫決策過程(Markov Decision Processes, 簡記為 MDPs)和隨機...A. Filar教授等合作,在部分可觀察的MDPs和擾動分析,連續時間MDPs和隨機對策,...

郭先平教授從事馬爾可夫決策過程(Markov Decision Processes, 簡記為 MDPs)和隨機...A. Filar教授等合作,在部分可觀察的MDPs和擾動分析,連續時間MDPs和隨機對策,...

(1993) "無限時段部分可觀察馬爾可夫決策規劃", Appl. J. Chinese Uni.,8(2):208-221.(1992) "Optimal Policies about Discounted Vector-valued Markovian ...