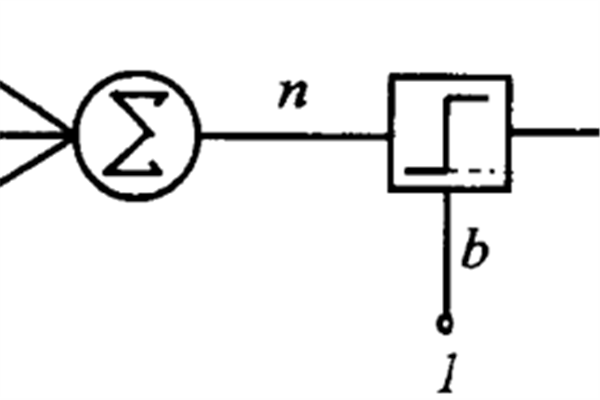

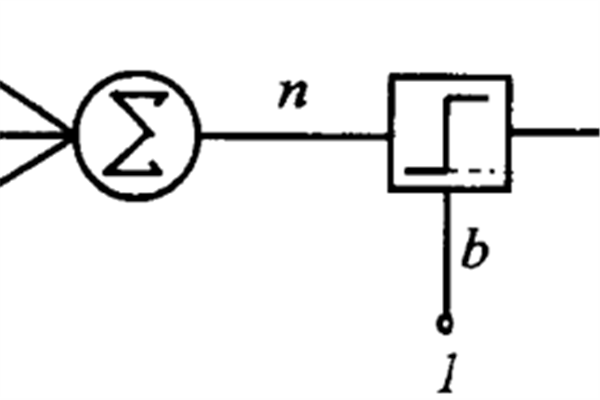

感知器是人工神經網路中的一種典型結構, 它的主要的特點是結構簡單,對所能解決的問題 存在著收斂算法,並能從數學上嚴格證明,從而對神經網路研究起了重要的推動作用。

基本介紹

- 中文名:感知器

- 外文名:Perceptron

- 最高境界:生物感知器

- 別稱:感知機

- 提出者:Frank Rosenblatt

- 分類:單層感知器,多層感知器

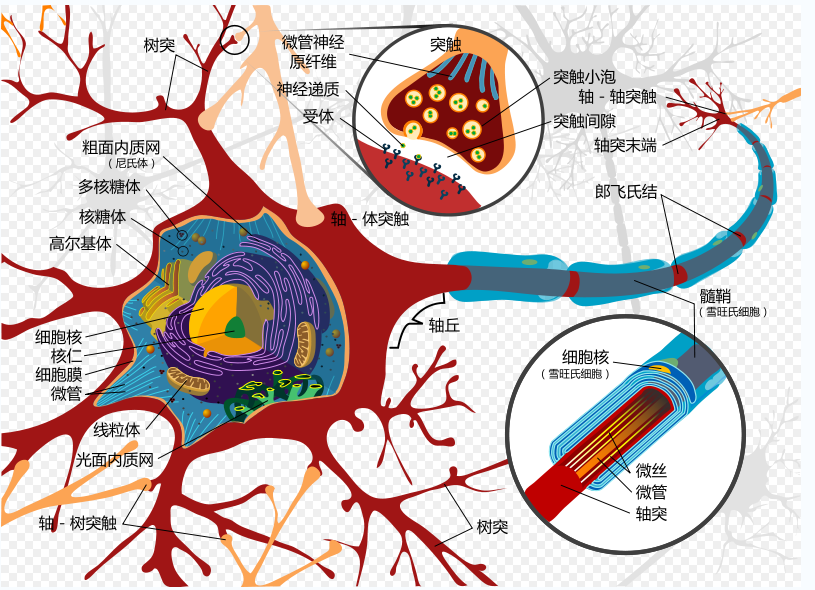

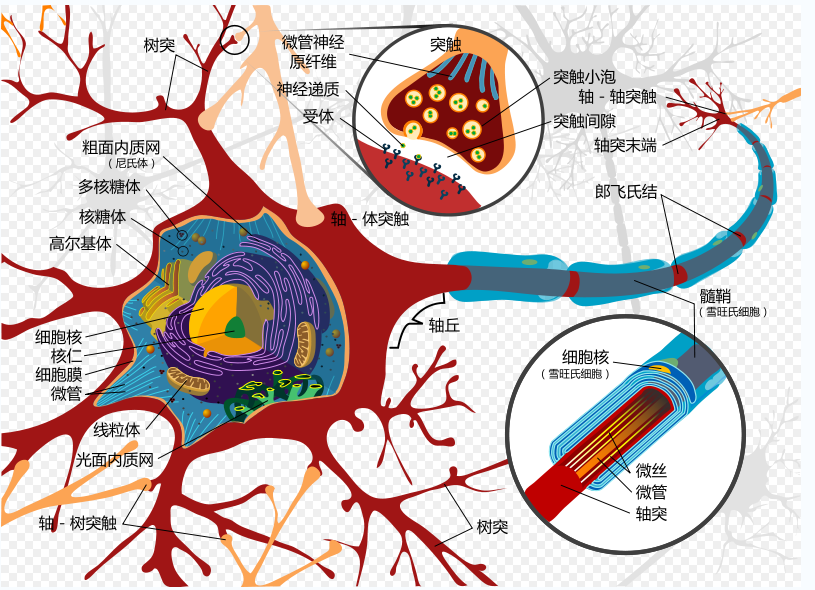

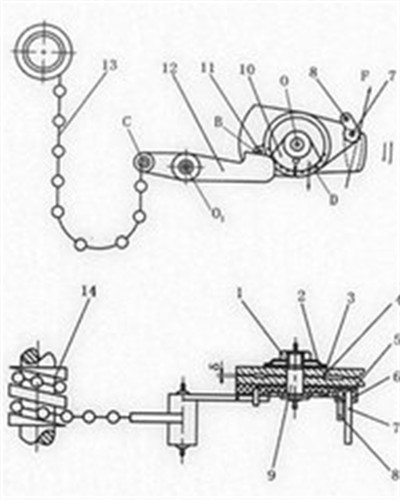

圖1.神經細胞示意圖

圖1.神經細胞示意圖起源

感知器

感知器 感知器

感知器數學描述

感知器是人工神經網路中的一種典型結構, 它的主要的特點是結構簡單,對所能解決的問題 存在著收斂算法,並能從數學上嚴格證明,從而對神經網路研究起了重要的推動作用。

圖1.神經細胞示意圖

圖1.神經細胞示意圖 感知器

感知器 感知器

感知器

感知器是人工神經網路中的一種典型結構, 它的主要的特點是結構簡單,對所能解決的問題 存在著收斂算法,並能從數學上嚴格證明,從而對神經網路研究起了重要的推動...

感知器(Perceptor)是《變形金剛》中的人物,(G1中變形為顯微鏡)。在《變形金剛之雷霆艦隊》中,感知器是由巷戰小組(鋼絲、突擊手、衝浪板)合體而成的組合金剛。...

曾經是霸天虎軍事顧問的黑暗感知器被誣陷,因為他的位置是霸天虎們夢寐以求的。他被趕下台,被流放到了邊遠地區,他的搭檔是Ga'medePhotogallery。在e-Hobby限定的...

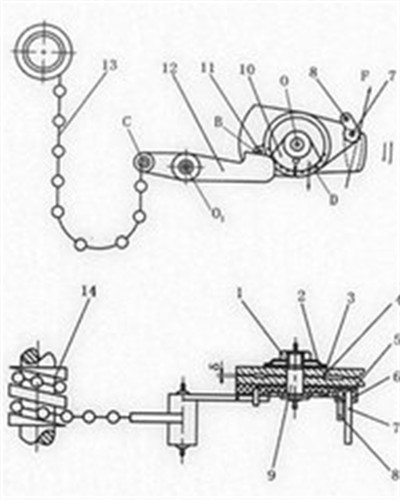

自動續絲機上感知在維生絲纖度的機構。分為:(1)定粒式,以定粒數方式間接感知生絲纖度,感知粒數受到煮熟繭浮沉、給繭機雙添、機械感知器靈敏度等因素影響而...

多層感知器(MLP,Multilayer Perceptron)是一種前饋人工神經網路模型,其將輸入的多個數據集映射到單一的輸出的數據集上。...

張力式纖度感知器,張力式纖度感知器是利用在繅生絲在定長拉伸下粗細變化與生絲張力成正比原理而設計,前蘇聯在20世紀60年代曾採用過,但此種張力受到煮熟繭解舒...

氧氣感知器(Oxygen Sensor) 排氣管的裝置之一,可測量廢氣中的含氧量,並將此訊號透過電壓訊號送至ECU,作為調整混合比之參考。 ...

PERCEPTOR MINI-CON TEAM 感知器迷你戰士小隊格言:“協力合作是成功之本。”...... PERCEPTOR MINI-CON TEAM 感知器迷你戰士小隊格言:“協力合作是成功之本。”...

人工智慧與信息感知 作者:王雪 定價:89元 印次:1-1 ISBN:9787302499756 出版日期:2018.06.01 印刷日期:2018.06.20 本書系統全面地介紹了人工智慧與信息感知...

多層前饋神經網路有一個輸入層,中間有一個或多個隱含層,有一個輸出層。多層感知器網路中的輸入與輸出變換關係為這時每一層相當於一個單層前饋神經網路,如對第 ...

MLP(Multi-Layer Perception),即多層感知器,是一種趨向結構的人工神經網路,映射一組輸入向量到一組輸出向量。MLP可以被看做是一個有向圖,由多個節點層組成,每一...

依選擇被控制量的不同,感知器一般可分為定粒感知器和定纖感知器兩種。定粒感知器以緒頭粒數作為被控制量,而定纖感知器通常以絲條通過感知器所產生的摩擦力...

1 簡介 2 特點 3 例子 ▪ 插入排序 ▪ 感知器 ▪ 貪心算法 線上算法簡介 編輯 在計算機科學中,一個線上算法是指它可以以序列化的方式一個個的處...

第八章用回傳算法訓練多層感知器 8.1神經網路的學習能力 8.2誤差回傳算法 8.3訓練模式 8.4回傳算法的改進 8.5將受控學習看做函式最最佳化問題 8.6網路推廣 第九章...

要控制能引擎,就必須有許多感應器 (Sensor) 來接收並傳遞引擎運轉信息,一具引擎通常會有進氣溫度感知器 (IAT Sensor)、油門開度感知器 (TPS Sensor)、歧管壓力...