基本介紹

- 中文名:中文切詞

- 外文名:Chinese Word Segmentation

- 性質:一個漢字序列切分成單獨的詞

- 重要性:文本挖掘的基礎

中文切詞(又稱中文分詞,Chinese Word Segmentation)指的是將一個漢字序列切分成一個一個單獨的詞。中文分詞是文本挖掘的基礎,對於輸入的一段中文,成功的進行中文...

中文分詞。分詞就是將連續的字序列按照一定的規範重新組合成詞序列的過程。我們知道,在英文的行文中,單詞之間是以空格作為自然分界符的,而中文只是字、句和段能...

中文自動分詞指的是使用計算機自動對中文文本進行詞語的切分,即像英文那樣使得中文句子中的詞之間有空格以標識。中文自動分詞被認為是中文自然語言處理中的一個最基本...

《中文文本自動分詞和標註》是2000年商務印書館出版的一本圖書,作者是劉開瑛。該書主要介紹了信息處理用現代漢語分詞詞表的收詞原則和方法。...

分詞可以有自己的狀語、賓語或邏輯主語等。中文名 分詞 外文名 participle 特徵 具有動詞及形容詞二者特徵 結構 現在分詞doing,過去分詞done 表示 進行,完成,...

分詞技術就是搜尋引擎針對用戶提交查詢的關鍵字串進行的查詢處理後根據用戶的關鍵字串用各種匹配方法進行分詞的一種技術。中文名 分詞技術 套用領域 搜尋引擎 基本...

Java分散式中文分詞組件 - word分詞...... Java分散式中文分詞組件 - word分詞 word分詞[1] 是一個Java實現的分散式的中文分詞組件,提供了多種基於詞典的分詞算法,...

中文名 百度分詞 外文名 Baidu participle 作用 查詢處理 技術: 字元串匹配的分詞方法 目錄 1 字元匹配 ▪ 百度分詞方法 ▪ 機械分詞方法 2 分類 ...

現在分詞(present participle)(又稱-ing形式,現在進行式) ,是分詞的一種,分詞...中文名 現在分詞 外文名 present participle 別稱 -ing形式 現在進行時 類別...

庖丁解牛分詞器是基於lucene的中文分詞系統的軟體。...... 庖丁解牛分詞器是基於lucene的中文分詞系統的軟體。中文名 庖丁解牛分詞器 基於 lucene的中文分詞系統 ...

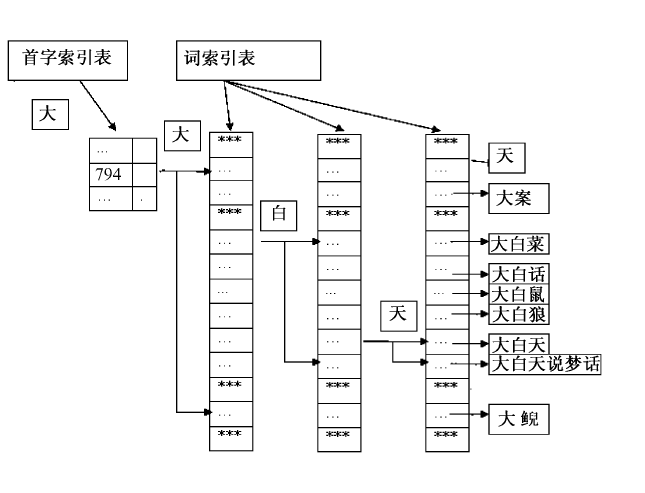

自動分詞是基於字元串匹配的原理進行的;所謂自動分詞方法,指的是漢字字元串匹配的進行方式。中文名 自動分詞 性質 分詞 屬性 自動 是漢字 字元串匹配的進行方式 ...

過去分詞(past participle)是分詞的一種。規則動詞的過去分詞一般是由動詞加-ed構成(規則見後)。中文名 過去分詞 外文名 past participle 別稱 過去分詞 套用...

獨立主格一般需自帶主語。若省去其主語,則為獨立主格中的特殊情況,即為“懸垂分詞”。中文名 懸垂分詞 科目 英語 屬性 特殊情況 對象 獨立主格中的 目錄 1 ...

中文名 俏佳人 俏佳人 就是極為俊俏而美麗的女子 俏佳人 應該是很完美的時代女性 具很強的 感召力和引領時代風潮的能力 目錄 1 分詞解釋 2 歷史典故 俏佳人...

Java分散式中文分詞組件 - word分詞...... Java分散式中文分詞組件 - word分詞 word分詞[1] 是一個Java實現的分散式的中文分詞組件,提供了多種基於詞典的分詞算法,...

中文名 尤其 外文名 particularly;especially 拼音 yóu qí 詞性 副詞 解釋 表示特別;更進一步 目錄 1 詞性 2 分詞解釋 3 造句 ...

中文詞法分析是中文信息處理的基礎與關鍵。中國科學院計算技術研究所在多年研究工作積累的基礎上,研製出了漢語詞法分析系統ICTCLAS(Institute of Computing Technology,...

robbe是建立在friso中文分詞組件上的一個高性能php中文分詞擴展,同時支持對UTF-8/GBK編碼的切分。此外,還提供了一些實用的php擴展函式,例如:編碼轉換。...

IKAnalyzer是一個開源的,基於java語言開發的輕量級的中文分詞工具包。...... IKAnalyzer是一個開源的,基於java語言開發的輕量級的中文分詞工具包。中文名 IKAnalyzer ...