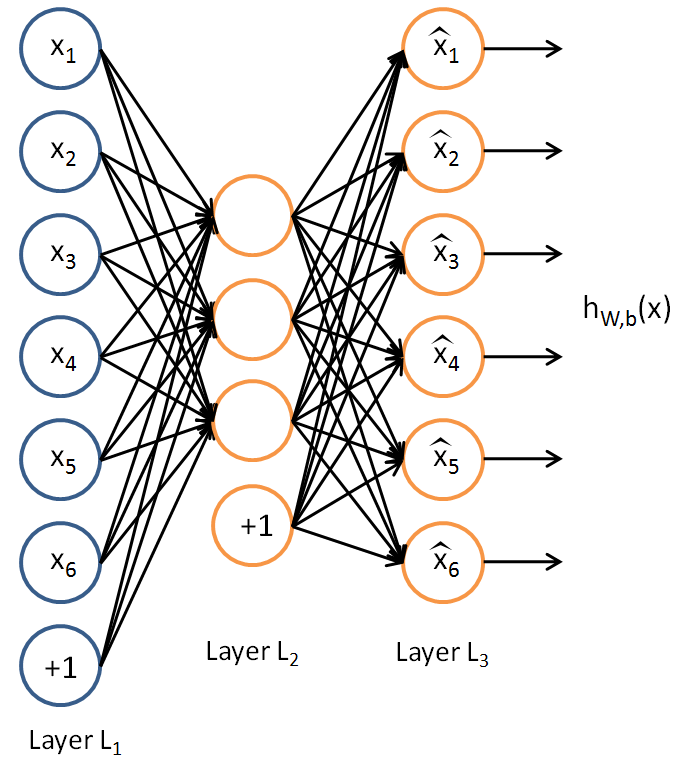

自編碼,又稱自編碼器(autoencoder),是神經網路的一種,經過訓練後能嘗試將輸入複製到輸出。自編碼器(autoencoder)內部有一個隱藏層h,可以產生編碼(code)表示輸入。該網路可以看作由兩部分組成:一個由函式h = f(x) 表示的編碼器和一個生成重構的解碼器r = g(h)。

基本介紹

- 中文名:自編碼

- 外文名:autoencoder

- 領域:深度學習

- 作用:特徵提取、數據降維

- 套用:文本分類、惡意檢測

- 變體:欠完備自編碼器、稀疏自編碼器、變分自編碼器

自編碼,又稱自編碼器(autoencoder),是神經網路的一種,經過訓練後能嘗試將輸入複製到輸出。自編碼器(autoencoder)內部有一個隱藏層h,可以產生編碼(code)表示輸入。該網路可以看作由兩部分組成:一個由函式h = f(x) 表示的編碼器和一個生成重構的解碼器r = g(h)。

自編碼,又稱自編碼器(autoencoder),是神經網路的一種,經過訓練後能嘗試將輸入複製到輸出。自編碼器(autoencoder)內部有一個隱藏層h,可以產生編碼(code)表示輸入...

自編碼結構,是一種人工神經網路,在無監督學習中用於有效編碼。自編碼的目的是對一組數據學習出一種表示(也稱表征,編碼),通常用於降維。最近,自編碼的概念廣泛地...

稀疏自編碼器是一種無監督機器學習算法,通過計算自編碼的輸出與原輸入的誤差,不斷調節自編碼器的參數,最終訓練出模型。自編碼器可以用於壓縮輸入信息,提取有用的...

為了進一步提高利用遙感圖像進行水體提取的準確率和自動化程度,提出一種基於棧式自編碼(SAE)深度神經網路的水體提取方法。通過堆疊稀疏自編碼器構建深度網路模型,使用...

正則自編碼器使用的損失函式可以鼓勵模型學習其他特性,並非將輸入複製到輸出。...... 正則自編碼器使用的損失函式可以鼓勵模型學習其他特性,並非將輸入複製到輸出。...

收縮自編碼器(contractive autoencoder,CAE)是一種正則自編碼器。它在編碼h=f(x)的基礎上添加了顯示的正則項,鼓勵 f 的導數儘可能小,它的懲罰項Ω(h) 是...

自編碼器(autoencoder)是神經網路的一種,經過訓練後能嘗試將輸入複製到輸出。從自編碼器獲得有用特徵的一種方法是限制 h 的維度比 x 小,這種編碼維度小於輸入...

去噪自編碼器(denoising autoencoder,DAE)是一類接受損壞數據作為輸入,並訓練來預測原始未被損壞數據作為輸入的自編碼器。...

自編碼器(autoencoder)是神經網路的一種,經過訓練後能嘗試將輸入複製到輸出。該網路可以看作由兩部分組成:一個由函式h=f(x)表示的編碼器和一個生成重構的解碼...

卷積神經網路所取得的各種優異表現直接推動了卷積自編碼器的產生。嚴格上來說,卷積自編碼器屬於傳統自編碼器的一個特例,它使用卷積層和池化層替代了原來的全連線層...

分形編碼(Fnactal Coding)壓縮技術是指尋求一幅圖像中的一組分形,由於這些分形具有“自相似性和尺度變化的無限性”特徵,所以只需保留數量非常小的分形數據,就可以...

預測稀疏分解(predictive sparse decomposition,PSD)是稀疏編碼和參數化自編碼器的混合模型。該模型由一個編碼器f(x)和一個解碼器g(h)組成,並且都是參數化的。在...

H.264,同時也是MPEG-4第十部分,是由ITU-T視頻編碼專家組(VCEG)和ISO/IEC動態圖像專家組(MPEG)聯合組成的聯合視頻組(JVT,Joint Video Team)提出的高度壓縮數字...

12.2.1基於自適應自編碼和超像素的SAR圖像分類12.2.2基於卷積中層特徵學習的SAR圖像分類12.3基於第一代深度神經網路的PolSAR影像地物分類...

Compressor是蘋果推出的運行於Mac OS X的一款視頻編輯軟體,主要功能有格式支持、編碼選項、圖像序列支持、格式與標準轉換等。...

自編碼:853539ISBN:9787802104921開本:16開頁數:260裝幀:平裝使圓成方:規範自我的12項修煉精彩品薦 編輯 青少年風華正茂,渴望吸引人他人的眼光,渴望成功,然而這必須...

三星YP-35H這款產品採用立式設計,金屬外殼,支持MP3和WMA格式的音樂檔案,採用SRS、WOW等Surround音樂效果,可錄音;自編碼錄音還有升級的功能。...