基本介紹

- 中文名:學習矢量量化

- 外文名:Learning Vector Quantization

- 簡稱:LVQ

- 提出者:Kohonen

- 提出時間:1988年

- 套用:統計學、模式識別、機器學習等

簡介

分類

結構

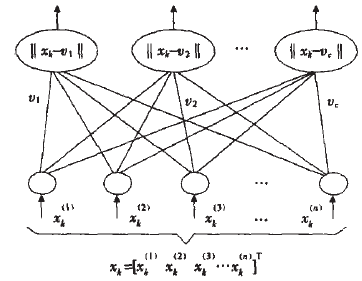

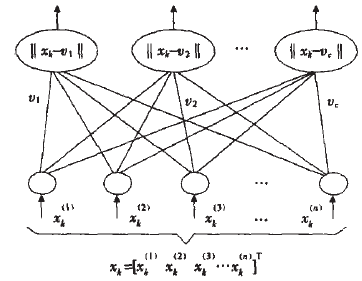

圖1 LVQ的結構圖

圖1 LVQ的結構圖LVQ算法

LVQ1

LVQ2.1

圖1 LVQ的結構圖

圖1 LVQ的結構圖

學習矢量量化(Learning Vector Quantization),簡稱LVQ,於1988年由Kohonen提出的一類用於模式分類的有監督學習算法,是一種結構簡單、功能強大的有監督式神經網路分類方法...

8.7 學習矢量量化網路8.8 支持向量機8.9 姜寨聚落遺址矢量特徵的神經網路空間分類研究第9章 矢量特徵的遺傳算法空間分類9.1 引言9.2 進化計算的研究現狀...

2.7神經算法:感知器神經網路,Hopfield網路,學習矢量量化、自組織映射。 3.擴展 3.1高級主題:編程範例,設計新的算法,測試算法、可視化算法,解決問題的策略,基準測試算...

第八章 Kohonen網路和學習矢量量化8、1 概述8、2 K-均值算法8、2、1 K-均值算法舉例8、3 Kohonen模型介紹8、3、1 Kohonen網路示例...

7.3 學習矢量量化7.4 主分量分析7.5 仿真實例7.6 習題第8章 協同神經網路8.1 協同學簡介8.2 協同神經網路8.3 仿真實例8.4 習題...

8.2模糊鑑別學習矢量量化(129)8.2.1算法描述(129)8.2.2實驗結果(130)8.3一種廣義噪聲聚類(131)8.3.1算法描述(131)8.3.2實驗結果(132)...

5.3.2 自適應共振理論的學習5.3.3 自適應共振理論的MATLAB程式5.4 學習矢量量化神經網路5.4.1 學習矢量量化的神經網路模型5.4.2 學習矢量量化神經網路的學習...

作為項目負責人,完成的成果“學習矢量量化的研究及其在視頻圖象編碼中的套用”獲得2006年廣東省科技進步二等獎和2006年度深圳市科技創新獎。完成的成果“數字水印技術...

10.4.1 學習矢量量化10.4.2 支持向量機10.5 基於狀態預測的退化10.5.1 異常狀態分類器的機率估計原理10.5.2 使用支持向量機的異常狀態的機率估計10.6 ...

3.4.3 SOM網的學習算法1063.4.4 學習矢量量化網路1083.4.5 自組織競爭網路的實現1093.5 反饋神經網路1183.5.1 Hopfield神經網路1183.5.2 Elman神經網路124...

[2]於龍,肖建,白裔峰.基於批量模糊學習矢量量化的模糊系統辨識,控制與決策, 2007, 22(8): 903-906. (EI)[3]於龍,肖建,周聰.魯棒區間類型2可能性C均值...

10.4.1 學習矢量量化10.4.2 支持向量機10.5 基於狀態預測的退化10.5.1 異常狀態分類器的機率估計原理10.5.2 使用支持向量機的異常狀態的機率估計10.6 ...