搜尋引擎通過一種程式“蜘蛛”(又稱spider),自動訪問網際網路上的網頁並獲取網頁信息。您可以在您的網站中創建一個純文本檔案robots.txt,在這個檔案中聲明該網站中不想被蜘蛛訪問的部分,這樣,該網站的部分或全部內容就可以不被搜尋引擎訪問和收錄了,或者可以通過robots.txt指定使搜尋引擎只收錄指定的內容。搜尋引擎爬行網站第一個訪問的檔案就是robots.txt。

基本介紹

- 中文名:robots協定

- 外文名:robots.txt

- 位置:網站根目錄

- 用途:指引搜尋引擎訪問網站頁面的檔案

搜尋引擎通過一種程式“蜘蛛”(又稱spider),自動訪問網際網路上的網頁並獲取網頁信息。您可以在您的網站中創建一個純文本檔案robots.txt,在這個檔案中聲明該網站中不想被蜘蛛訪問的部分,這樣,該網站的部分或全部內容就可以不被搜尋引擎訪問和收錄了,或者可以通過robots.txt指定使搜尋引擎只收錄指定的內容。搜尋引擎爬行網站第一個訪問的檔案就是robots.txt。

搜尋引擎通過一種程式“蜘蛛”(又稱spider),自動訪問網際網路上的網頁並獲取網頁信息。您可以在您的網站中創建一個純文本檔案robots.txt,在這個檔案中聲明該網站中不...

robots是網站跟爬蟲間的協定,用簡單直接的txt格式文本方式告訴對應的爬蟲被允許的許可權,也就是說robots.txt是搜尋引擎中訪問網站的時候要查看的第一個檔案。當一個...

機器人(Robot)是自動執行工作的機器裝置。它既可以接受人類指揮,又可以運行預先編排的程式,也可以根據以人工智慧技術制定的原則綱領行動。它的任務是協助或取代人類...

上述的robots.txt和Robots Meta標籤限制搜尋引擎機器人(ROBOTS)抓取站點內容的辦法只是一種規則,需要搜尋引擎機器人的配合才行,並不是每個ROBOTS都遵守的。目前看來,...

機器人是Robot英文直譯,在搜尋引擎最佳化SEO中,我們經常翻譯為:探測器。有時,你會碰到crawlew(爬行器),spider(蜘蛛),都是探測器之一,只是叫法不同。...

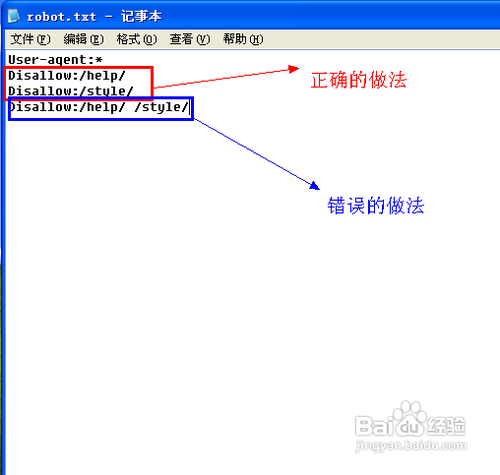

或者也可以建一個空robots.txt檔案。 禁止所有蜘蛛訪問網站的任何部分,格式如下: User-agent:* Disallow:/ 禁止所有蜘蛛訪問網站的某幾個部分,比如下例中禁...

hellotxt是你個人的社會的NetWorker,是為您的網上生活的社會控制板。我們的免費服務,通過WEB,WAP,智慧型手機應用程式的訪問,旨在幫助用戶溝通,很容易與他們的接觸,無...

Robot Framework是開源軟體,由Nokia Siemens Networks開發並提供支持。... Robot Framework是開源軟體,由Nokia Siemens Networks...1.測試用例使用文本檔案(TXT或者TSV檔案...

當然,Robots.txt只是一個協定,如果網路蜘蛛的設計者不遵循這個協定,網站管理員也無法阻止網路蜘蛛對於某些頁面的訪問,但一般的網路蜘蛛都會遵循這些協定,而且網站管理...

阿里巴巴外貿“機器人”(,簡稱AliRobot),是中國第一款阿里巴巴國際站自動化行銷...關鍵字批量輸入,就可以隨時查到產品的排名在第N頁第M位,並能導出一個TXT報告...

一般情況下,大多數網站創建者或管理員都會在網站的根目錄放置一個名為robots.txt的文本檔案,用來控制自己的網站哪些目錄允許SE搜尋引擎 [1] 爬行並收錄,哪些目錄...

最近的商業搜尋軟體,如Ask Jeeves,MSN和Yahoo可以在robots.txt中使用一個額外的 “Crawl-delay”參數來指明請求之間的延遲。對連線間隔時間的第一個建議由Koster ...

目錄 1 系統優點 2 網站特點 3 Robots.txt verycms系統優點 編輯 全站靜態目錄部署 VeryCMS系統整體採用phpwind獨有的偽靜態設計思想--針對搜尋引擎地特殊處理...

當然,Robots.txt只是一個協定,如果網路蜘蛛的設計者不遵循這個協定,網站管理員也無法阻止網路蜘蛛對於某些頁面的訪問,但一般的網路蜘蛛都會遵循這些協定,而且網站管理...