高速緩衝存儲器(Cache)簡稱快存,是為了解決CPU和主存之間速度匹配問題而設定的,由於快存技術難度和製造成本較高,計算機系統中一般採用多級快存。L1快取,即一級快取(Level 1 Cache),也簡稱L1 Cache,位於CPU核心的旁邊,是與CPU結合最為緊密的CPU快取,通常訪問只需要幾個周期,通常是幾十個KB大小。

基本介紹

- 中文名:L1快取

- 外文名:Level 1 Cache

- 學科:計算機

- 別名:一級快取

- 目的:實現CPU快速存取

- 領域:計算機系統

高速緩衝存儲器(Cache)簡稱快存,是為了解決CPU和主存之間速度匹配問題而設定的,由於快存技術難度和製造成本較高,計算機系統中一般採用多級快存。L1快取,即一級快取(Level 1 Cache),也簡稱L1 Cache,位於CPU核心的旁邊,是與CPU結合最為緊密的CPU快取,通常訪問只需要幾個周期,通常是幾十個KB大小。

一級快取即L1 Cache。集成在CPU內部中,用於CPU在處理數據過程中數據的暫時保存。由於快取指令和數據與CPU同頻工作,L1級高速快取快取的容量越大,存儲信息越多,可...

高速快取(英語:cache,/kæʃ/ kash )簡稱快取,原始意義是指訪問速度比一般隨機存取存儲器(RAM)快的一種RAM,通常它不像系統主存那樣使用DRAM技術,而使用昂貴...

L2快取位於CPU與記憶體之間的臨時存儲器,容量比記憶體小但交換速度快,二級快取容量大小決定了cpu的性能。...

高速緩衝存儲器(Cache)其原始意義是指存取速度比一般隨機存取記憶體(RAM)來得快...從理論上講,在一顆擁有2級Cache的CPU中,讀取L1Cache的命中率為80%。也就是說...

在計算機系統中,CPU高速快取(英語:CPU Cache,在本文中簡稱快取)是用於減少處理器訪問記憶體所需平均時間的部件。在金字塔式存儲體系中它位於自頂向下的第二層,僅次於...

L2高速快取就是指可以進行高速數據交換的存儲器,它先於記憶體與CPU交換數據,因此速度極快,所以又被稱為高速快取。與處理器相關的快取一般分為兩種——L1快取,也稱...

快取是CPU的一部分,它存在於CPU中 CPU存取數據的速度非常的快,一秒鐘能夠存取、處理十億條指令和數據(術語:CPU主頻1G),而記憶體就慢很多,快的記憶體能夠達到幾十兆...

快取是指臨時檔案交換區,電腦把最常用的檔案從存儲器里提出來臨時放在快取里,就像把工具和材料搬上工作檯一樣,這樣會比用時現去倉庫取更方便。因為快取往往使用的...

一級快取都內置在CPU內部並與CPU同速運行,可以有效的提高CPU的運行效率。一級快取越大,CPU的運行效率越高,但受到CPU內部結構的限制,一級快取的容量都很小。...

高速緩衝存儲器(Cache)簡稱快存,是為了解決CPU和主存之間速度匹配問題而設定的,由於快存技術難度和製造成本較高,計算機系統中一般採用多級快存。L1快取,即一級快取...

三級快取是為讀取二級快取後未命中的數據設計的—種快取,在擁有三級快取的CPU中,只有約5%的數據需要從記憶體中調用,這進一步提高了CPU的效率。其運作原理在於使用較...

高速快取(英語:cache,/kæʃ/ kash )簡稱快取,原始意義是指訪問速度比一般隨機存取存儲器(RAM)快的一種RAM,通常它不像系統主存那樣使用DRAM技術,而使用昂貴...

客戶端快取,用戶端程式 臨時檔案交換區,電腦把最常用的檔案從存儲器里提出來臨時放在快取里。...

一級快取是相對於二級快取來命名的,它是直接與CPU數據匯流排相連,傳輸速度接近於CPU處理速度。而二級快取主要是進一步過度一級快取和記憶體直接的傳輸速度差。CPU快取(...

動態快取,計算機術語,用於臨時檔案交換,快取是指臨時檔案交換區,電腦把最常用的檔案從存儲器里提出來臨時放在快取里,就像把工具和材料搬上工作檯一樣,這樣會比用時...

同理,構造磁碟高速緩衝存儲器(簡稱磁碟Cache),也將提高系統的整體運行速度CPU一般設有一級快取(L1 Cache)和二級快取(L2 Cache)。一級快取是由CPU製造商直接做在...

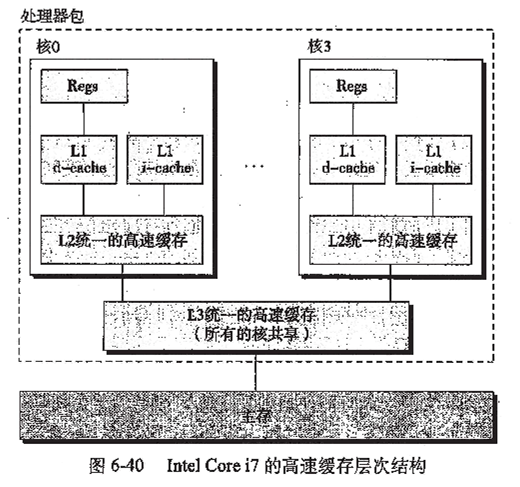

L1 Cache(一級快取)是CPU第一層高速快取,分為數據快取和指令快取。內置的L1高速快取的容量和結構對CPU的性能影響較大,不過高速緩衝存儲器均由靜態RAM組成,結構較...

(Core Microarchitecture)的骨架上,外加增添了SMT、3層快取、TLB和分支預測的...在這種情況下,它們的關係就象L1快取和L2快取一樣(因為分支目標也具有相當好的...

Cache又分為L1Cache(一級快取)和L2Cache(二級快取),L1Cache主要是集成在CPU...Cache存儲器:電腦中為高速緩衝存儲器,是位於CPU和主存儲器DRAM(Dynamic Random ...