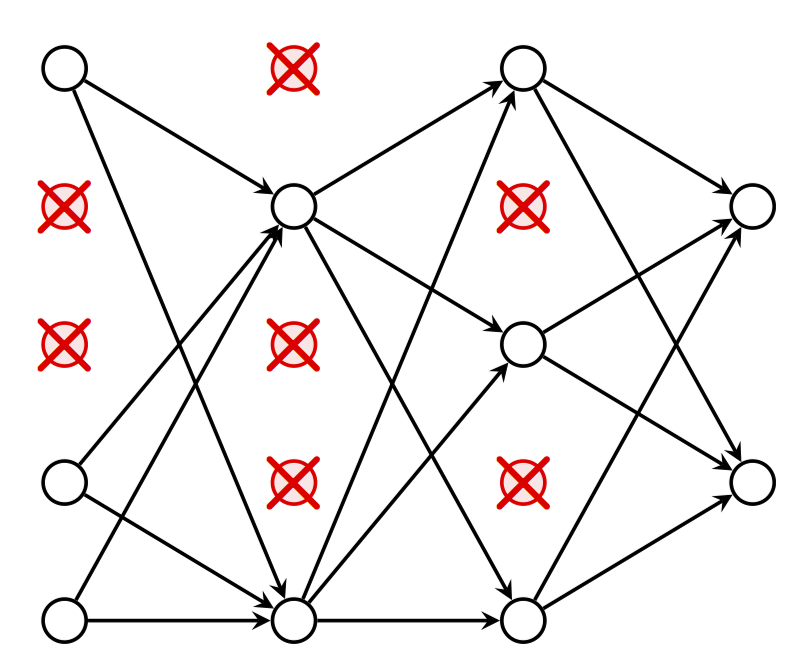

隨機失活(dropout)是對具有深度結構的人工神經網路進行最佳化的方法,在學習過程中通過將隱含層的部分權重或輸出隨機歸零,降低節點間的相互依賴性(co-dependence )從而實現神經網路的正則化(regularization),降低其結構風險(structural risk)。

基本介紹

- 中文名:隨機失活

- 外文名:dropout

- 提出者:G. Hinton,N. Srivastava,A. Krizhevsky 等

- 提出時間:2012年

- 學科:人工智慧

隨機失活(dropout)是對具有深度結構的人工神經網路進行最佳化的方法,在學習過程中通過將隱含層的部分權重或輸出隨機歸零,降低節點間的相互依賴性(co-dependence )從而實現神經網路的正則化(regularization),降低其結構風險(structural risk)。

隨機失活(dropout)是對具有深度結構的人工神經網路進行最佳化的方法,在學習過程中通過將隱含層的部分權重或輸出隨機歸零,降低節點間的相互依賴性(co-dependence )從而...

哺乳動物雌性個體的X染色體失活遵循n-1法則,不論有多少條X染色體,最終只能隨機保留一條的活性。對有多條X染色體的個體研究發現有活性的染色體比無活性的染色體提前...

因為母貓有兩條X染色體,玳瑁貓的出現源於X染色體的隨機失活現象。 雌性玳瑁白色貓 凡是毛色黃、黑相間的貓都是雌性的,這是因為黃色毛基因(b)是X連鎖隱性基因,...

格式中rate接收一個0和1之間的浮點數,表示隨機失活的比率。Dropout中noise_shape表示隨機失活對張量各個維度的操作,例如對輸入張量(t,x,y),給定noise_shape=(1...

AlexNet在卷積層中選擇ReLU作為激勵函式,使用了隨機失活,和數據增強(data data augmentation)技術 [68] ,這些策略在其後的卷積神經網路中被保留和使用 [26] 。Al...

人類女性的 X染色體失活在胚胎髮育的第16天就已發生,而且那一條X染色體失活是隨機的。其他有胎盤的哺乳動物也類同,但有袋類(如雌性袋鼠)失活的X染色體是有...

因Rett綜合徵主要累及女性,過去較為普遍的觀點為X連鎖顯性遺傳,男性胚胎致死,並引入X染色體非隨機失活的假設。但近來的研究不支持Rett綜合徵致病基因位於X染色體,雙...

人類女性的 X染色體失活在胚胎髮育的第16天就已發生,而且哪一條X染色體失活是隨機的。其他有胎盤的哺乳動物也類同,但有袋類(如雌性袋鼠)失活的X染色體是有...

因為即使基因型一致,基因表達還會受到甲基化、體細胞突變、X染色體的隨機失活等影響。中文名 易感性 外文名 susceptibility 簡介 由遺傳基礎所決定個體患病的風險 ...

植入子宮壁時)失活;(3)兩條X染色體中哪一條失活是隨機的;(4)X染色體失活後,細胞繼續分裂形成的克隆中,此條染色體都是失活的;(5)生殖細胞形成時失活的 X...

三、X染色體隨機失活的機制 第五節 核外遺傳 一、核外遺傳現象 二、人的線粒體遺傳病 三、線粒體DNA的結構 四、線粒體DNA的套用 五、母性遺傳與母性影響 ...

這兩種嵌鑲的位置在個體之間明顯不同,這是由於發育期一條X染色體隨機失活所致。三色貓(又叫做三玳瑁貓)也是一個很好的例子。雌性的三色貓腹部的毛是白色的,背部...

選擇失效過程是一個隨機過程,發生在早期胚胎髮育階段。 [1] 由於幾乎所有雌性哺乳動物有兩條X染色體,X染色體失活防止她們有比男性(只擁有一條X染色體的一個副本)...

30%的女性攜帶者因X染色體的隨機失活而發病,但通常只顯示出輕度的智力發育障礙。參考資料 1. 傅松濱.醫學遺傳學(第三版):北京大學醫學出版社,2013 ...

在前饋神經網路中被使用和證實有效的隨機失活(dropout)策略也可用於循環神經網路。在輸入序列的維度大於1時,循環神經網路在每個時間步的輸入和狀態的矩陣元素都可以...

Warwick大學研究人員發現,由於飲食、心理、環境等因素的影響,女性X染色體受自殺基因的影響會出現隨機失活,導致免疫調節失控、內分泌失調,進而引發各種婦科疾病。及時...

11?2X染色體失活11?2?1X染色體隨機失活的 起始11?2?2Xist RNA介導的X染色體 沉默以及失活X染色體的 異染色質化11?3基因組印記11?3?1哺乳動物的印記基因...

女性雜合子臨床表現複雜,嚴重患者於胎兒期~嬰兒期死亡,輕型患者終身不發病, 一些嚴重酶缺失的女性患者仍然能夠存活,主要決定於X 染色體隨機失活的形式。[4] PDH ...

Warwick大學研究人員發現,由於飲食、心理、環境等因素的影響,女性X染色體受自殺基因的影響會出現隨機失活,導致免疫調節失控、內分泌失調,進而引發各種婦科疾病。及時...

人類女性的X染色體失活在胚胎髮育的第16天就已發生,而且那一條X染色體失活是隨機的。其他有胎盤的哺乳動物也類同,但有袋類(如雌性袋鼠)失活的X染色體是有選擇...