基本介紹

- 中文名:搜尋引擎算法

- 搜尋引擎舉例:Google、百度

- 變革意義:引領第四代搜尋引擎的升級

- 依賴軟體:網路機器人或叫網路蜘蛛

搜尋引擎算法: 獲得網站網頁資料,建立資料庫並提供查詢的系統,我們都可以把它叫做搜尋引擎。搜尋引擎的資料庫是依靠一個叫“網路機器人(crawlers)”或叫“網路蜘蛛(...

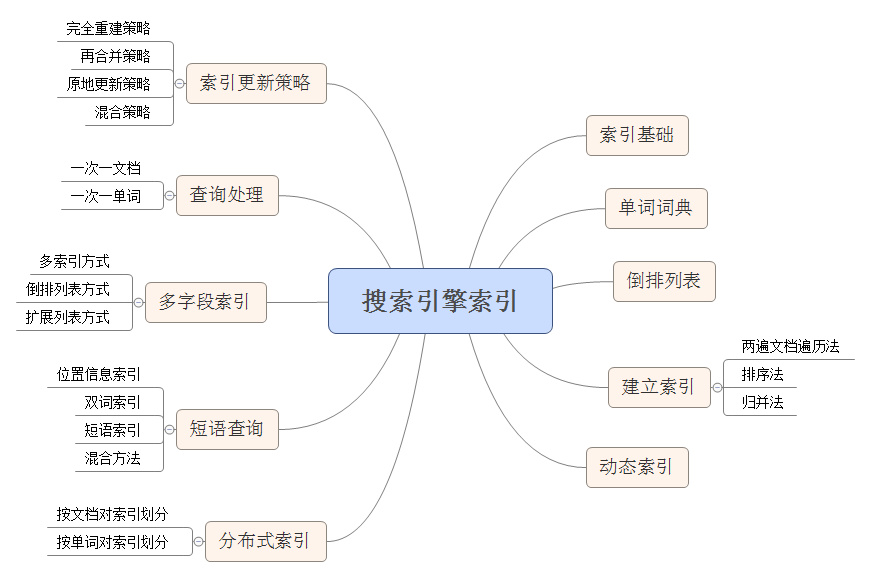

搜尋引擎的基本工作原理包括如下三個過程:首先在網際網路中發現、蒐集網頁信息;同時對信息進行提取和組織建立索引庫;再由檢索器根據用戶輸入的查詢關鍵字,在索引庫中...

谷歌搜尋算法這是一個很普通的搜尋,谷歌每天要處理成千上萬的這種搜尋。但事實上這一搜尋過程十分複雜,可能使一些搜尋引擎誤解。如果把這些單詞輸入到必應,第一個...

搜尋引擎爬蟲 (又被稱為網頁蜘蛛,網路機器人),是一種按照一定的規則,自動的抓取全球資訊網信息的程式或者腳本。...

隨著網際網路的迅猛發展、WEB信息的增加,用戶要在信息海洋里查找自己所需的信息,就象大海撈針一樣,搜尋引擎技術恰好解決了這一難題。搜尋引擎是指網際網路上專門提供檢索...

搜尋引擎排名指搜尋引擎派出一個能夠在網上發現新網頁並抓取檔案的程式,這個程式通常被稱為蜘蛛(spider)或者機器人(robot)。搜尋引擎蜘蛛從資料庫中已知的網頁開始...

排名算法是指各大搜尋引擎用來對其索引中的結果列表進行評估和排名的規則,英文名是Ranking Algorithm。網站內容原創、圖片添加alt標籤等均可列為算法的影響因素。如果...

谷歌搜尋技術所依託的軟體可以同時進行一系列的運算,且只需片刻即可完成所有運算。中文名 谷歌搜尋引擎運算技術 目錄 1 算法介紹 2 功能 谷歌搜尋引擎運算技術算法...

每一個搜尋引擎幾乎都有自己的規則,合理的SEO可以有效提高網站的排名,從而使得行銷更加的容易和簡單。所以,掌握搜尋引擎的算法更新技術是進行SEO的重要方法。...

SEO(Search Engine Optimization):漢譯為搜尋引擎最佳化。搜尋引擎最佳化是一種利用搜尋引擎的搜尋規則來提高目前網站在有關搜尋引擎內的自然排名的方式。SEO的目的理解是...

搜尋引擎,通常指的是收集了全球資訊網上幾千萬到幾十億個網頁並對網頁中的每一個詞(即關鍵字)進行索引,建立索引資料庫的全文搜尋引擎。當用戶查找某個關鍵字的時候,...

本書向讀者提供了一套完整的大數據時代背景下的搜尋引擎解決方案,詳盡地介紹了搜尋引擎的技術架構、算法體系及取得的效果,以模組化的方式進行組織。著重介紹了機器...

《自己動手寫搜尋引擎》是2009年電子工業出版社出版的圖書,作者是羅剛。本書全方位展現出一個商用級別的Lucene搜尋解決方案。...

《搜尋引擎:原理、技術與系統》是2005年4月1日科學出版社出版的圖書,作者是李曉明,閆宏飛,王繼民。...

本書是暢銷書升級版,向讀者提供了一套完整的大數據時代背景下的搜尋引擎解決方案,詳盡地介紹了搜尋引擎的技術架構、算法體系及取得的成果,並以模組化的方式進行組織...

SEO(Search Engine Optimization):漢譯為搜尋引擎最佳化。是一種方式:利用搜尋引擎的規則提高網站在有關搜尋引擎內的自然排名。目的是:為網站提供生態式的自我行銷解決...

SES(Search Engine Services)即搜尋引擎服務。整合了目前所有與搜尋引擎相關的項目,為實現在搜尋引擎上的特定展示效果而圍繞搜尋引擎所開展的專業化、系統化並給客戶...

《搜尋引擎技術基礎》是2010年清華大學出版社出版的圖書,作者是劉弈群、馬少平、洪濤、劉子正。...

搜尋引擎收錄是指程式通過辨別把網站內容進行收錄,它在讀取你內容的時候,同時會對這些內容進行價值以及其他方面的辨別。...

3.2.5 元搜尋引擎和搜尋聚合器 513.3 算法的變化 513.4 人類是智慧的,而計算機不是523.5 文本內容 533.5.1 關鍵字的選擇是關鍵所在 53...

抓取目標的描述和定義是決定網頁分析算法與URL搜尋策略如何制訂的基礎。而網頁分析算法和候選URL排序算法是決定搜尋引擎所提供的服務形式和爬蟲網頁抓取行為的關鍵所在。...