基本介紹

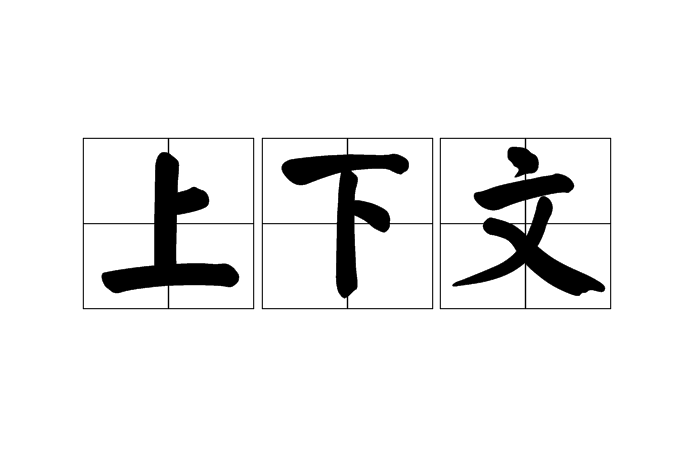

- 中文名:上下文

- 外文名:context

- 類別:IT,Java

語境

語意分析

實作方式

奇異值分解

- M的左奇異向量(left-singular vectors)是MM的特徵向量。

- M的右奇異向量(right-singular vectors)是MM的特徵向量。

- M的非零奇異值 (在Σ的對角列上)之平方根則是MMandMM共同的特徵值。

上下文,即語境、語意,是語言學科(語言學、社會語言學、篇章分析、語用學、符號學等)的概念。語意分析(semantic analysis)技術系指將一長串的文字或內容,從其中...

上下文切換(Context Switch),性質為環境切換。上下文切換,有時也稱做進程切換或任務切換,是指CPU 從一個進程或執行緒切換到另一個進程或執行緒。...

進程上下文,意思是可執行程式代碼是進程的重要組成部分。進程上下文實際上是進程執行活動全過程的靜態描述。...

上下文對象是web伺服器上基於web套用的一個背景環境對象,上下文對象提供了一個同一web套用內不同資源間共享信息的場所。舉個例子安卓中的上下文對象...

上下文有關文法的概念是諾姆·喬姆斯基在1950年代作為描述自然語言的語法的一種方式介入的,在自然語言中一個單詞是否可以出現在特定位置上要依賴於上下文。可以被上下文...

所有的繪圖都由圖形上下文(graphics context,GC)來完成,在Symbian Os中定義了一個抽象類CGraphicsContext來統一圖形上下文。...

設G =(VN,VT,P,S)為一文法,若中的每一個產生式均滿足|β|>=|α|,僅僅α→ε除外,則文法G是1型或上下文有關的。* 2型文法(上下文無關文法)(context...

在上下文關係圖中擺放基礎元素,並捕獲它們之間的關係。使用最初的Booch標記法,系統和參與者都可以使用雲圖來表示。...

上下文無關文法(英語:context-free grammar,縮寫為CFG),在計算機科學中,若一個形式文法G = (N, Σ, P, S) 的產生式規則都取如下的形式:V->w,則謂之。...

上下文相關文法(context-sensitive language)一種短語結構文法.是喬姆斯基(Chomsky, N.)引進的.設G=(V,T,P,s)為一個短語結構文法,若限定式中的所有產生式a->...

諸暨市草塔鎮上下文村,位於諸暨市草塔鎮西南部,五洩江支流石瀆溪穿村而過,為原尚文、霞紋兩村合併而成。是”紹興市全面小康示範村”、“浙江省歷史文化保護利用...

上下文效應,背景(上下文)會影響到社會判斷。這種上下文效應有兩類:對比和同化。對比指一種歪曲效應,它使做出的判斷與環境背景相違反。譬如說,在評判照片中人物的...

上下文關聯幫助(Context-sensitive help),又稱“上下文敏感幫助”,屬於線上幫助的一種,它提供與程式當前位置和狀態相關聯的幫助信息。上下文關聯幫助為用戶提供即時幫助...

'是一種集邏輯等一起的計算規律,分為隱式和顯式兩類'。上下文計算是從已知到未知的方法,包括計算,推理,設計等,有無限計算和有限計算兩類。並且有認識的無限的...

在形式文法理論中,確定上下文無關文法(DCFG)是上下文無關文法的真子集。...... 確定上下文無關文法是確定下推自動機可識別的文法。確定上下文無關語言是確定上下文...

“路漫漫其修遠兮,吾將上下而求索”出自屈原《離騷》第97句。結合上下文可理解為:道路又窄又長無邊無際,我要努力尋找心中的太陽。結合上下文則表達了屈原“趁天...

上下文無關語言是可以用上下文無關文法定義的形式語言。所有上下文無關語言的集契約一於下推自動機所接受的語言的集合。...

上下文無關解析就是對無關上下文的分析。...... 程式語言大部分是上下文無關語言,查詢語言通常也是上下文無關語言。英語也可以看成是上下文無關語言。這些語言中的字...

隨機上下文無關文法(英語:Stochastic context-free grammar),即在上下文無關文法中,為每一個產生式規則賦予一個機率,標示套用一個產生式規則的可能性。...

保留上下文索引系統是計算機輔助標引系統,又稱保持原意索引法。也稱為context。...... 保留上下文索引系統是計算機輔助標引系統,又稱保持原意索引法。也稱為context。...

塊格式化上下文(Block Formatting Context,BFC)是Web頁面的可視化CSS渲染的部分,是塊級盒布局發生的區域,也是浮動元素與其他元素互動的區域。有這幾種框會為其內容...

windows提供設備描述表,用於應用程式和物理設備之間進行互動,從而提供了應用程式設計的平台無關性。設備描述表又稱為設備上下文,或者設備環境。...

ResetDC,一種函式,該函式根據指定結構中的信息更新給定印表機或繪圖儀的設備上下文環境。...

該函式檢索指定視窗客戶區域或整個螢幕的顯示設備上下文環境的句柄,在隨後的GDI函式中可以使用該句柄在設備上下文環境中繪圖。...

PCFG(Probabilistic Context Free Grammar),機率上下文無關文法,或稱為SCFG(Stochastic Context Free Grammar),隨機上下文無關文法。...

wglShareLists是使多個OpenGL渲染上下文共享一個顯示列表的空間 。...... 指定與共享顯示列表的OpenGL渲染上下文。hglrc2指定分享hglrc1顯示列表的OpenGL渲染上下文。當 ...